騰訊云TACO-LLM加速模塊,榮耀AI底座性能飛躍新高度

在生成式AI技術飛速發(fā)展的浪潮中,手機行業(yè)正經(jīng)歷著前所未有的變革。各大手機制造商紛紛將AI技術融入其最新產(chǎn)品中,并以驚人的速度進行迭代升級。榮耀作為行業(yè)內(nèi)的佼佼者,更是在AI大模型的部署上邁出了重要一步。

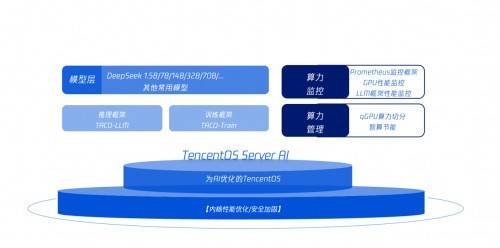

為了提升大模型部署的效能,榮耀選擇了騰訊云TencentOS Server AI中的TACO-LLM加速模塊,并成功將其應用于DeepSeek-R1等開源大模型的部署中。這一舉措不僅限于技術層面的嘗試,更在實際應用中取得了顯著成效。榮耀在企業(yè)內(nèi)部等多個場景中,通過TACO-LLM加速模塊的加持,實現(xiàn)了穩(wěn)定性、可靠性和推理性能的全面提升。

在推理平臺場景中,榮耀尤為注重框架效能、穩(wěn)定性、運行狀態(tài)監(jiān)控及應急預案等關鍵特性。在DeepSeek-R1滿血版場景下,使用TACO-LLM進行推理任務后,相較于榮耀原始線上業(yè)務性能,首Token延遲(TTFT)P95的響應時間降低了最高達6.25倍,吞吐量則提升了2倍,端到端延遲更是降低了100%。而在社區(qū)最新版本sglang場景下,TTFT P95的響應時間更是實現(xiàn)了最高12.5倍的降低。

TACO-LLM之所以能夠為榮耀的業(yè)務性能帶來如此顯著的提升,主要得益于其獨特的投機采樣技術核心能力。傳統(tǒng)的大語言模型自回歸解碼屬性在GPU算力利用上存在不足,計算效率低下,解碼成本高昂。而TACO-LLM通過投機采樣的方式,從根本上解決了這一問題,實現(xiàn)了大模型的“并行”解碼,從而顯著提高了解碼效率。

榮耀大數(shù)據(jù)平臺部的相關負責人對此表示:“通過采用騰訊云的TACO-LLM技術,榮耀成功打造了高性能的AI底座。這一底座不僅部署穩(wěn)定可靠,更在性能加速方面為我們帶來了前所未有的體驗。”這一評價無疑是對TACO-LLM加速模塊在榮耀實際應用中成效的最好證明。

TencentOS Server AI加速版中的TACO-LLM加速模塊,針對企業(yè)級AI模型私有化部署的挑戰(zhàn),進行了專門的內(nèi)核運行優(yōu)化。這一優(yōu)化旨在提高大語言模型的推理效能,提供兼顧高吞吐和低延時的優(yōu)化方案。更重要的是,TACO-LLM加速模塊能夠“無縫”整合到現(xiàn)有的大模型部署方案中,為榮耀等企業(yè)的AI應用提供了更加便捷和高效的解決方案。

?????投稿郵箱:jiujiukejiwang@163.com ??詳情訪問99科技網(wǎng):http://www.hacbq.cn

OPPO攜手阿里云,大數(shù)據(jù)平臺實現(xiàn)云端遷移新突破

OPPO攜手阿里云,大數(shù)據(jù)平臺實現(xiàn)云端遷移新突破

近期,阿里云宣布與智能手機制造商OPPO攜手,成功將OPPO龐大的大數(shù)據(jù)平臺遷移

快資訊2025-07-22

頭條資訊

頭條資訊 推薦資訊

推薦資訊